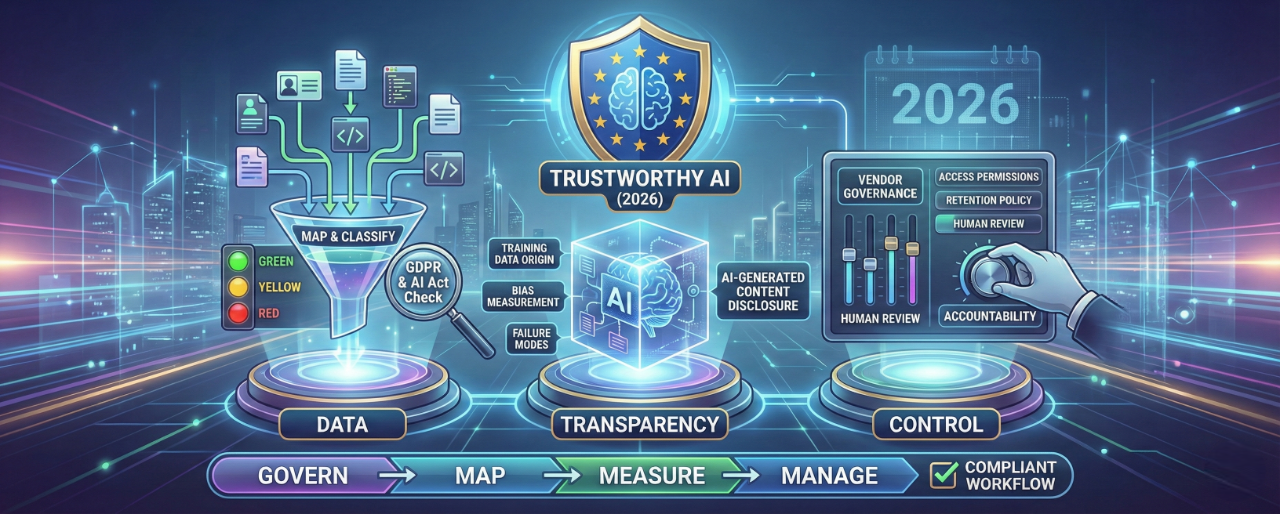

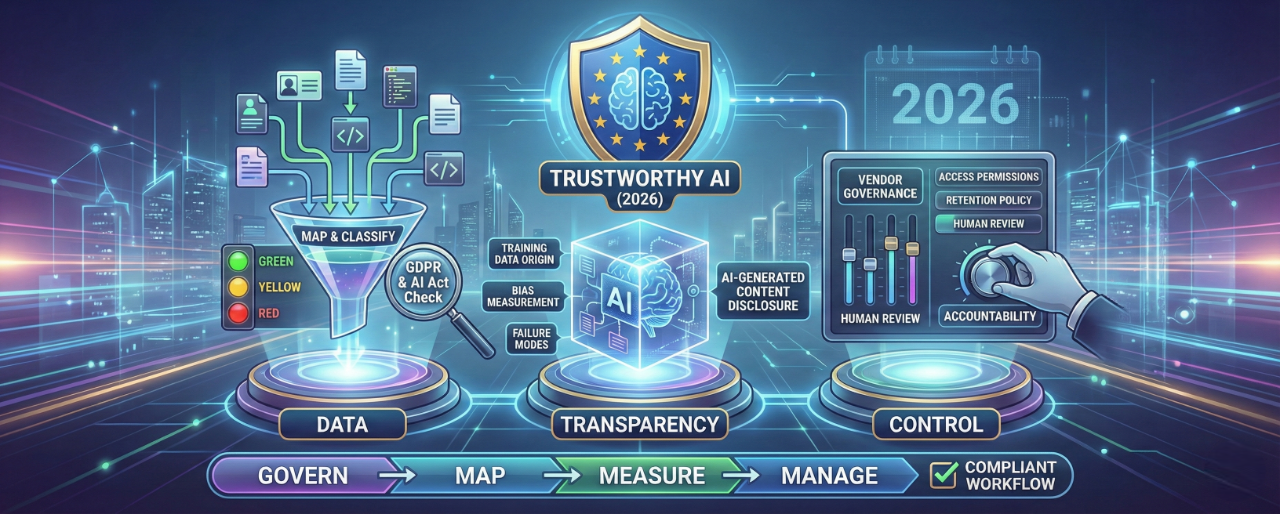

Vertrauenswürdige KI in 2026: Daten, Transparenz und Kontrolle

KI ist längst kein „Experimentier-Tool“ mehr. Sie wird zur Infrastruktur: fürs Schreiben, den Kundenservice, Recruiting, Analytics, Produktentscheidungen und Content-Erstellung. Damit wird KI automatisch zu einem Vertrauensthema. Denn sobald Sie ein KI-Modell einsetzen, treffen Sie, oft ohne es zu merken, Entscheidungen über:

Dieser Artikel liefert Ihnen ein praxisnahes, business-taugliches Framework, um KI verantwortungsvoll und glaubwürdig zu nutzen - inklusive einer konkreten Checkliste, die Sie direkt in eine interne KI-Policy übernehmen können.

Die meisten KI-Probleme in Unternehmen entstehen nicht, weil das Modell „schlecht“ ist, sondern weil Erwartungen und Realität nicht zusammenpassen:

In der EU wird diese Vertrauensebene zunehmend reguliert; vor allem durch den EU AI Act, der am 1. August 2024 in Kraft getreten ist und ab 2. August 2026 vollständig gilt. Einzelne Pflichten gelten bereits früher, u. a. zu verbotenen Praktiken und KI-Kompetenz (AI Literacy).

1) Was passiert mit meinen Daten?

Bei den meisten KI-Plattformen können Ihre Eingaben u. a. enthalten:

Das führt direkt zu klassischem Datenschutzdenken:

Unter der DSGVO ist Sicherheit explizit gefordert (risikobasiert) - inklusive Maßnahmen zur Vertraulichkeit, Integrität, Verfügbarkeit und Belastbarkeit.

2) Wer trägt die Verantwortung?

Selbst wenn ein Modell „entscheidet“, bleibt Ihr Unternehmen verantwortlich für:

Deshalb ist Governance oft wichtiger als „das beste Modell“ zu finden.

Der EU AI Act arbeitet risikobasiert und unterscheidet Pflichten je nach Rolle, u. a. für Provider (Anbieter) und Deployer (Nutzer im Business-Kontext).

A) KI-Kompetenz ist nicht mehr optional

Ab 2. Februar 2025 verpflichtet der AI Act Organisationen dazu, ein ausreichendes Niveau an AI literacy bei Mitarbeitenden und weiteren Personen sicherzustellen, die KI im Auftrag des Unternehmens nutzen.

Praktisch heißt das: Wenn Ihr Team KI bei der Arbeit nutzt, brauchen Sie Training und klare Regeln.

B) Transparenzpflichten (Deepfakes + KI-Interaktionen)

Der AI Act sieht Transparenzanforderungen u. a. in folgenden Fällen vor:

Auch wenn Sie keine Deepfakes bauen: Das Mindset „labeln & offenlegen“ wird zur Best Practice für Vertrauen.

C) General-Purpose AI (GPAI) wird stärker reguliert

Für General-Purpose-Modelle (GPAI) veröffentlicht die EU-Kommission Leitlinien und unterstützende Dokumente zu Pflichten, u. a. zu Transparenz rund um Trainingsdaten und urheberrechtliche Erwartungen. Wenn Sie GPAI-Plattformen nutzen, ist das relevant, weil:

Verantwortlicher vs. Auftragsverarbeiter (und warum das wichtig ist)

Wenn Sie eine KI-Plattform einsetzen, um personenbezogene Daten zu verarbeiten, müssen Sie klären:

Wenn der Anbieter Auftragsverarbeiter ist, brauchen Sie einen Auftragsverarbeitungsvertrag (AVV / DPA) (DSGVO Art. 28). Der Vertrag muss u. a. Regeln zu Weisungen, Subdienstleistern, Sicherheitsmaßnahmen etc. enthalten.

Sicherheitsanforderungen sind ausdrücklich geregelt

Die DSGVO verlangt „geeignete“ Maßnahmen (risikobasiert). Das ist mehr als „wir nutzen HTTPS“. Es geht um Zugriffssteuerung, Logging, Incident Response und klare Prozesse.

Wann ist ein DSB in Deutschland erforderlich?

Das BDSG nennt eine häufig zitierte Schwelle: Ein Datenschutzbeauftragter ist grundsätzlich zu benennen, wenn ein Unternehmen regelmäßig mindestens 20 Personen beschäftigt, die ständig mit automatisierter Verarbeitung personenbezogener Daten befasst sind (§ 38 BDSG).

Unabhängig davon kann ein DSB nach DSGVO Art. 37 erforderlich sein, z. B. bei großskaliger Überwachung oder großskaliger Verarbeitung besonderer Kategorien von Daten.

Warum ein DSB bei KI auch unterhalb der Pflicht sinnvoll ist

Weil KI sehr schnell „versteckte Verarbeitung“ und Shadow Usage erzeugt. Ein DSB (intern oder extern) hilft dabei:

Ein praktisches Framework für vertrauenswürdige KI: Govern → Map → Measure → Manage

Wenn Sie ein einfaches Denkmodell wollen: Nutzen Sie die Struktur des NIST AI Risk Management Framework: Govern, Map, Measure, Manage. So übersetzen Sie das in einen umsetzbaren Unternehmensprozess:

1) GOVERN: Regeln festlegen, bevor KI „einfach genutzt“ wird

Praxisregel, die immer funktioniert:

Wenn ein Mitarbeitender etwas nicht in einem öffentlichen Forum posten würde, sollte es auch nicht in ein KI-Tool kopiert werden, außer es ist explizit freigegeben.

2) MAP: Daten & Risiko je Use Case verstehen

Dokumentieren Sie pro Use Case:

Nutzen Sie eine einfache 3-Stufen-Klassifizierung:

3) MEASURE: Verlässlichkeit, Bias und Failure Modes validieren

Bevor Sie KI-Outputs in produktive Workflows geben:

Dokumentieren Sie außerdem bekannte Grenzen:

4) MANAGE: Kontrollen für Tools und Anbieter etablieren

A) Anbieter-Checks

B) Security & Access Controls

C) Transparenz-Controls

Vertrauenswürdige KI entsteht nicht dadurch, dass man „das richtige Modell“ auswählt. Sie entsteht dadurch, dass man ein System um KI herum baut:

Mit dem gestaffelten Zeitplan des EU AI Act (AI Literacy und verbotene Praktiken bereits früher relevant; volle Geltung 2026) wird „wir kümmern uns später“ schnell teuer.

Wenn Sie ein greifbares Takeaway wollen: Kopieren Sie die Checkliste in Ihr internes Wiki und machen Sie daraus:

Und quartalsweises Review gemeinsam mit dem DSB/Security Owner.

Wenn Sie KI für viele Medien wie Video/Audio einsetzen, lesen Sie auch CHAMELAIONs DSGVO-Datenschutz-Checkliste für KI-Videoübersetzung.

Betrifft der EU AI Act auch Unternehmen, die KI nur nutzen (nicht bauen)?

Ja. Der AI Act enthält Pflichten für „Deployers“ (Organisationen, die KI-Systeme einsetzen), u. a. zu AI Literacy und Transparenz in bestimmten Kontexten.

Brauchen wir KI-Training für Mitarbeitende?

Ja, das ist dringend zu empfehlen. Der AI Act erwartet ab 2. Februar 2025 Maßnahmen, um ein ausreichendes Niveau an AI Literacy sicherzustellen für Mitarbeitende und Personen, die KI in Ihrem Auftrag nutzen.

Wann müssen wir KI-generierte Inhalte kennzeichnen?

Der AI Act enthält Transparenzanforderungen für KI-generierte bzw. KI-manipulierte Inhalte (Deepfakes) und weitere Szenarien. Best Practice ist ein klarer Disclosure-Standard für synthetische Inhalte in Marketing und Kommunikation.

Ist es okay, Kunden- oder Mitarbeiterdaten in ChatGPT-ähnliche Tools zu kopieren?

Das hängt von Ihrer Klassifizierung und Ihrem Vendor-Setup ab. Sobald personenbezogene Daten im Spiel sind, brauchen Sie:

Wann ist ein Datenschutzbeauftragter in Deutschland verpflichtend?

Nach § 38 BDSG muss ein DSB in vielen Fällen benannt werden, wenn regelmäßig mindestens 20 Personen ständig mit automatisierter Verarbeitung personenbezogener Daten befasst sind. Zusätzlich kann DSGVO Art. 37 einen DSB in bestimmten Fällen verlangen (z. B. großskalige Überwachung oder großskalige Verarbeitung sensibler Daten).

Was ist der häufigste Fehler im Umgang mit KI und Daten?

„Schatten KI“: Teams führen Tools individuell ein, Daten landen ungeplant in Prompts, und niemand kann Fragen zu Retention, Training oder Zugriffskontrolle beantworten. Das ist ein Vertrauensproblem - kein reines Technikproblem.

Übersetze Hindi und portugiesische Videos oder Audios mit CHAMELAION. Upload, Sprachen wählen, Translate klicken, dann previewen und in Minuten exportieren.

Übersetze spanische und arabische Videos oder Audios mit CHAMELAION. Upload, Sprachen wählen, Translate klicken, dann previewen und in Minuten exportieren.